Google 的数据中心以高能效著称。但是他们还不满足,在今天的 Data Centers Europe 2014上,Google数据中心副总裁Joe kava介绍了自己的公司是如何利用机器学习和人工智能来进一步改进数据中心能效的。

业界一般用PUE(电能使用效率)来衡量数据中心的能效,PUE=数据中心总设备能耗/IT设备能耗,其基准值为2,越接近1表明能效越高。Google之前的PUE已经达到了惊人的1.12,这说明其用于制冷与配电等的消耗已经很少。

但是Google决定利用神经网络让其数据中心能效更上一层楼。据Kava介绍,该项目属于Google的20%项目。他们每30秒就计算一次PUE,还不断跟踪IT设备能耗、机外气温以及制冷和机械设备的设置情况等。而Google数据中心团队成员Jim Gao对这些数据非常熟悉,他意识到这些数据还可以进一步利用。于是Gao通过机器学习对这些数据进行研究,并建立起模型来预测并进一步改进数据中心能效。

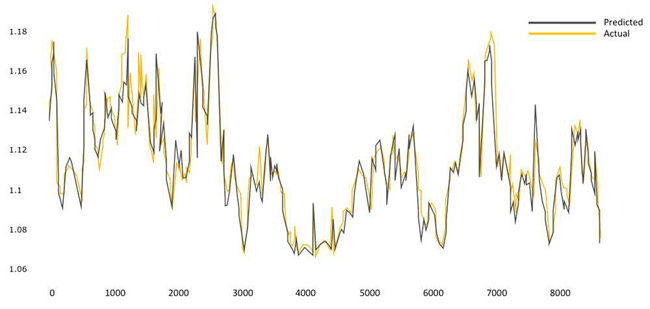

结果表明,该模型的预测准确率达到了99.6%(参见下图)。如果高的准确率意味着Google对数据中心下一步的能量需求情况了如指掌,从而可以通过设置调整进一步提升能效。Kava举了一个例子。几个月前,他们有几台服务器要下线几天,其结果是数据中心能效会有所降低。但利用Gao的模型他们临时调整了制冷设置,从而降低了那段时间对PUE的影响。

上述情况下Google进行电力基础设施升级要重新调整40%的服务器流量,但是通过PUE仿真与专家知识的结合,团队选定了一套新的运营参数,从而将PUE再降了0.02。不要小看这个值,考虑到Google有成千上万台服务器,乘上巨大的能耗就是可观的节能效果。

Gao在今天发布的白皮书上解释了自己的做法。他说神经网络对复杂系统建模具有优势,因为神经网络不需要用户预设模型的交互特征,而是在特征中寻找模式和交互,然后自动生成最佳匹配模型。

该神经网络研究的因素包括了服务器总负载,水泵、冷却塔、冷水机组、干式冷却器、运行中的冷水注水泵数量;冷却塔水温、湿球温度、户外湿度、风速、风向等。Google利用传感器部署了亿万个数据点来收集这些基础设施和电能使用信息。不过令人略为惊讶的是,Google只用一台服务器就能跑这个神经网络了。

Gao在白皮书中写道,Google数据中心的实际测试表明,机器学习是利用传感器数据对数据中心能效建模的一种有效方法,可带来显著的成本节省。不过国内较为粗放式管理的数据中心恐怕短时间内难以效仿。

河南亿恩科技股份有限公司(www.enkj.com)始创于2000年,专注服务器托管租用,是国家工信部认定的综合电信服务运营商。亿恩为近五十万的用户提供服务器托管、服务器租用、机柜租用、云服务器、网站建设、网站托管等网络基础服务,另有网总管、名片侠网络推广服务,使得客户不断的获得更大的收益。

服务器/云主机 24小时售后服务电话:

0371-60135900

虚拟主机/智能建站 24小时售后服务电话:

0371-55621053

网络版权侵权举报电话:

0371-60135995

服务热线:

0371-60135900